编者按:本文(含图片)为合作媒体放大灯(guokr233)授权创业邦转载,不代表创业邦立场。

字节不是第一个造芯的互联网公司。

在字节跳动之前,BAT三巨头早已下场造芯。其中,百度的行动最早。

早在2010年,百度就开始尝试研发AI芯片,一开始是合作,先后同ARM、紫光展锐和赛灵思等公司推出数款AI芯片,自研的昆仑芯片2代则发布于2020年9月。今年3月15日,百度昆仑芯片业务完成独立融资,昆仑2代也将不日量产。

阿里造芯的故事则与达摩院息息相关。2017年10月,达摩院成立时便把芯片列为研究的领域之一,后续研发出一款神经网络芯片——Ali-NPU。2018年9月的云栖大会上,达摩院院长张建锋宣布成立平头哥半导体公司。此后,平头哥陆续推出“含光”“玄铁”等系列芯片。其中,AI芯片含光800已经实现量产,用在了阿里巴巴的服务器上。

腾讯的动作更加低调。2018年,腾讯领投AI芯片创企燧原科技Pre-A轮融资,并在2019、2020年继续跟投后续轮次融资。2019年到2020年,燧原科技先后发布了云燧T10、T11和云燧i10三款AI芯片。2020年3月,腾讯又成立了深圳宝安湾腾讯云计算有限公司,其业务范围便包括“集成电路设计、研发”。

互联网公司造芯大事件 | 放大灯团队制图

至此,BAT三家互联网巨头全部杀进AI芯片的领域,展开竞争。

BAT的对手不光有英伟达、高通、赛灵思这样的国外芯片巨头,还有寒武纪、地平线这样专注于研发AI芯片的创企,也有华为海思这样的国产芯片头部企业。

互联网公司投入这么长的时间成本造芯,究竟看中了什么?

在半导体行业,英特尔创始人曾提出一个著名的“摩尔定律”:处理器的性能每18个月便会增加一倍。

但由于高温和漏电等技术原因,21世纪以来,CPU处理器性能翻倍的速度变得越来越慢。如今,CPU的算力已经无法满足人工智能技术的需要。互联网公司不得不抛弃CPU,另寻门路——做一种专门用于训练人工智能的“AI芯片”。

“AI芯片”之名源于它的用途,从技术路线上,GPU、FPGA芯片和ASIC芯片,都可以被用来做AI芯片。

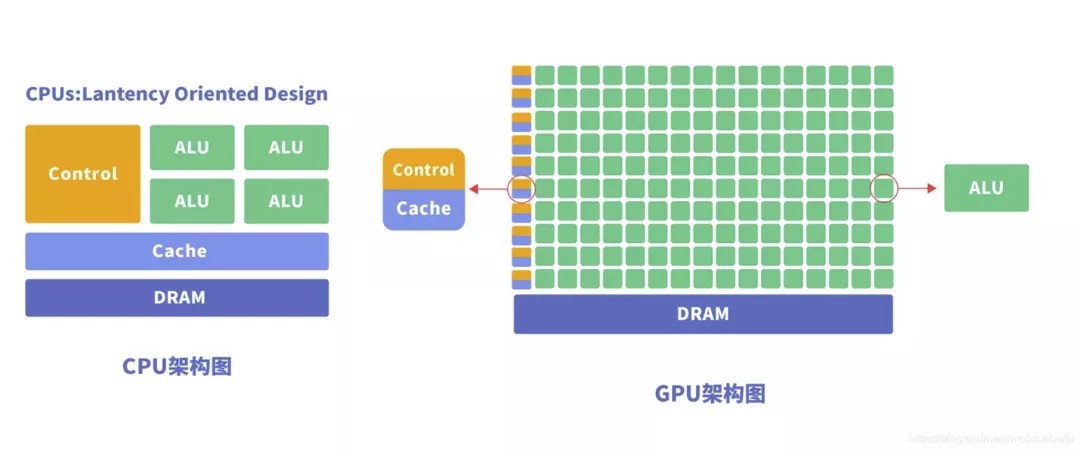

AI芯片与CPU相比,具有更多ALU(逻辑运算单元)。换句话说,两者是全才与专才的差别:CPU能够执行复杂指令,但算力因此受到限制,AI芯片虽只能执行简单指令,可它的算力却比CPU高得多。

CPU与GPU结构对比图:GPU拥有更多的ALU(逻辑运算单元)

恰巧,人工智能的训练和推理,就是一个简单的重复过程,用不到那么复杂的指令。因此,用AI芯片代替CPU往往能事半功倍。

AI芯片有没有什么缺点呢?也有。

因为AI芯片的指令简单,所以不像CPU那样“即插即用”。人工智能团队在应用AI芯片前,必须针对训练场景进行优化。

百度创始人李彦宏在谈及自研芯片的初衷时曾说:“2017年的时候,我们还是觉得这些市场上现有的解决方案和现有的技术,不能够满足我们对AI算力的要求。”[1]

为了开发最适合自家AI业务的芯片,互联网公司纷纷自研芯片。

AI芯片都用在了什么地方?在互联网公司,它们的去向主要有两个。

为了让你快乐冲浪,服务器变了“芯”

第一个去向,是互联网公司的云服务器。

近几年,中国的云业务市场越来越大。根据中国信通院发布的《云计算白皮书(2020年)》,2019年我国云计算整体市场规模为1334亿元,到2023年这个数字将接近4000亿元[2]。

巨大的云市场背后,是规模庞大的服务器。

根据Canalys的数据,截止2020年第三季度,中国头部四家云服务公司为阿里、华为、腾讯、百度。其中,三家互联网公司的服务器均超过百万台:

2019年5月,腾讯云总裁邱跃鹏宣布,腾讯全网服务器总量超过100万台,是中国首家服务器总量超过百万的公司[3];

2020年7月,阿里则表示总服务器规模接近200万,并且在南通、杭州和乌兰察布三座超级数据中心落成后将另新增百万[4];

同样是2020年7月,李彦宏在世界人工智能大会上称,到2020年,百度智能云的服务器数量超过500万台[5]。

另外,字节跳动在2020年5月,也推出了名为“火山引擎”的企业云服务平台[6]。“基于前沿的大数据、人工智能以及云基础技术能力,助力客户增长。”火山引擎在官网这样描述自己的业务。

服务器的性能,事关每一个用户。你能在微博吃到“三千万粉丝男星事件”的瓜、能在“3·15”的晚上看到流畅的晚会直播、能在半夜两点收到老板和客户的“关心”,这一切都离不开服务器。

怎么才能提高服务器的性能呢?答案之一是AI芯片。

大多数人的印象里,服务器就是一个个黑色的“柜子”。实际上,这些“柜子”的功能各有不同——有的用来储存数据、有的用来交换信息、有的用来运算和推理。

服务器就是这样的“柜子”们 | 图源:Pexels.com

AI芯片就用在这些运算、推理服务器上,提高它们的算力。

2019年云栖大会上,阿里就用4颗含光800芯片,代替了40颗传统GPU才能完成的视频处理任务。而前者的成本,只有后者的十分之一[7]。

IDC发布的2020年上半年《全球人工智能市场半年度追踪报告》,人工智能服务器是AI算力基础设施的主要角色,占全球人工智能基础设施市场的84.2%以上[8]。未来,中国的AI服务器将占全球市场的三分之一左右[9]。

让智能音箱不再“智障”

AI芯片的第二个去向,则是用于支持智能硬件,尤其是智能音箱。

根据西南证券的数据,2018~2020年,中国智能音箱三年出货量共计超过1.3亿台。其中绝大多数来自百度、阿里和小米三家公司[10]。

随着智能音箱的成功,智能硬件业务也成了互联网公司的重点业务。2020年1月,阿里的天猫精灵升级为独立事业部[11]。2020年9月,小度也从百度拆分,完成独立融资[12]。

作为公司重点业务,用户体验是一定要跟上的。

智能音箱的关键在于语音控制,而语音控制的核心,是自然语言处理(NLP)技术。

无论你家用的是小度在家还是天猫精灵,让智能音箱听懂“人话”的,都是AI芯片。

想让数以千万计的智能音箱,顺利进行自然语言处理,还要依靠AI芯片的算力。AI芯片公司壁仞科技联合创始人徐凌杰曾表示,对于数量庞大的NLP推理,还是需要GPU或者其他AI芯片提供算力支持[13]。

即便抛开互联网公司自身的需求,AI芯片本身也是一个诱人的市场。

根据赛迪顾问的数据,中国AI芯片市场规模会在2021年达到305.7亿元,增长率更是高达57.8%[14]。另据前瞻产业研究院的数据,我国AI芯片市场规模将在2024年达到785亿元[15]。

AI芯片是一个相对年轻的行业。与CPU行业相比,还没有哪家公司独占AI芯片的鳌头。这个市场养活了寒武纪、地平线、天数智芯等AI芯片创企,而近年来盯上AI的互联网公司,自然不愿放过这块“肥肉”。

当下但凡开展了云计算业务的公司,都想要自研AI芯片。BAT走在了前面,字节跳动不过是跟上它们的脚步罢了。

当然,在科技公司的造芯路上还有更多潜在的难题:前有2018年美国制裁中兴事件,后有美国国家人工智能安全委员会(NSCAI)的“卡脖子报告”(如果你对NSCAI的“卡脖子报告”感兴趣,我们建议你看看这篇文章:《反华科技报告背后的硅谷精英们》)。BAT们有了设计AI芯片的能力,后面还有漫长的生产环节,今天他们可以找到三星和台积电,但以后呢?

本文(含图片)为合作媒体授权创业邦转载,不代表创业邦立场,转载请联系原作者。如有任何疑问,请联系editor@cyzone.cn。